robots文件,robots文件的作用

1、robots文件是放在网站根目录下的一个文件robots文件,是搜索引擎与网站沟通的重要渠道robots文件,是网站与搜索引擎爬虫之间的协议robots文件,用于告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取robots文件注意事项搜索引擎差异性不同的搜索引擎,对robots文件的解析代码可能存在差异如果是使用星号*表示,则是适用于所有的搜索引擎因此,在编写robots文件时。

2、搜索引擎爬去robots文件我们页面的工具叫做搜索引擎机器人,也生动的叫做“蜘蛛”蜘蛛在爬去网站页面之前,会先去访问网站根目录下面的一个文件,就是robotstxt这个文件其实就是给“蜘蛛”的规则,如果没有这个文件,蜘蛛会认为你的网站同意全部抓取网页Robotstxr文件是一个纯文本文件,可以告诉蜘蛛哪些页面可以。

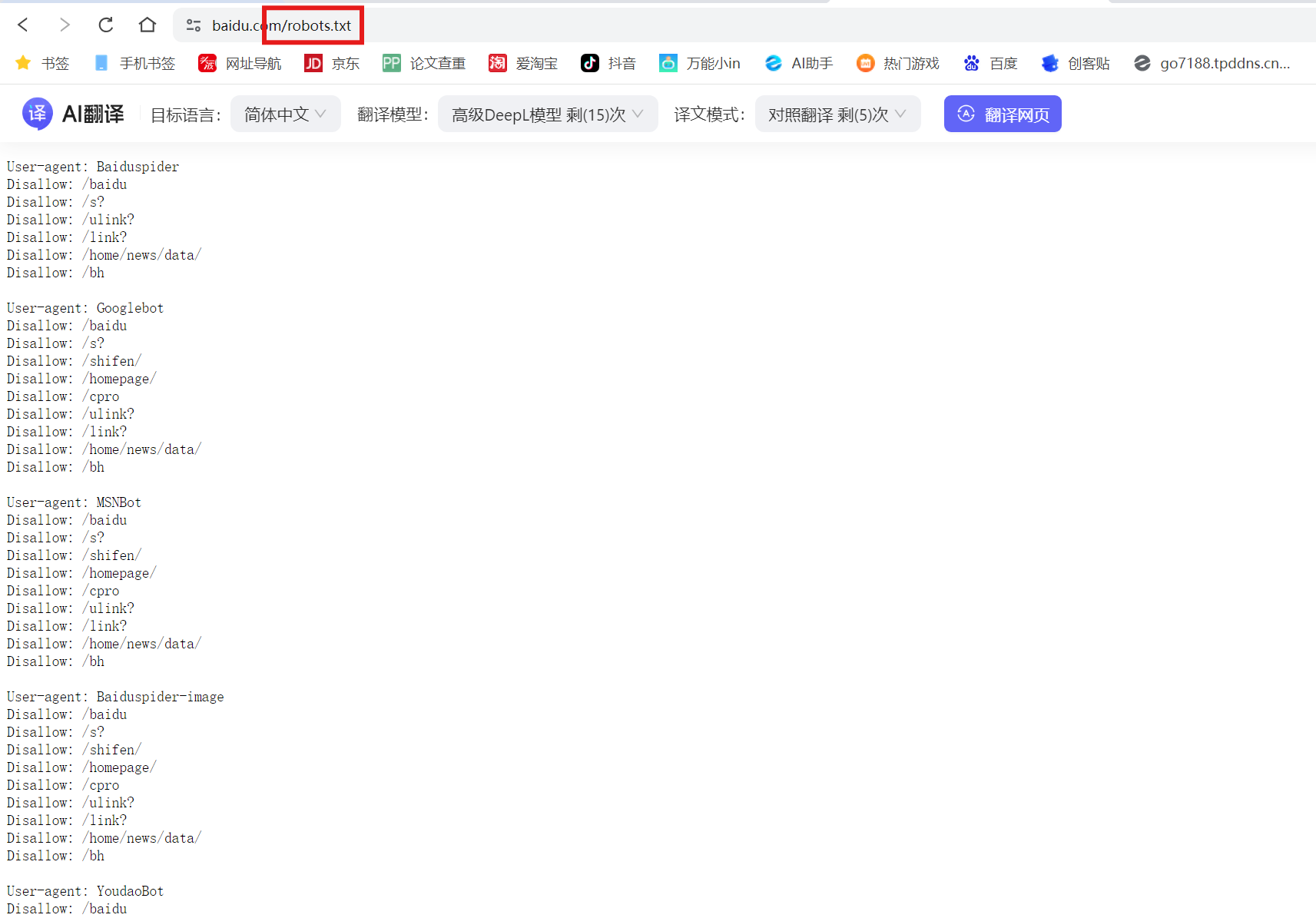

3、了解百度robotstxt文件的关键在于明确其为机器人协议,适用于所有搜索引擎,而不仅仅是百度此文件位于网站根目录,用于定义抓取规则,规定哪些内容可被抓取,哪些不可在robotstxt中,关键字指定对象,通常指搜索引擎爬虫,如谷歌的googlebot,百度的Baiduspider等文件中包含allow和disallow指令,前者指示。

4、robots文件中到底要不要屏蔽JS和cssrobotstxt文件中不需要专门屏蔽CSSJS等文件 因为robotstxt只是给搜索引擎蜘蛛爬去做限制的,告诉蜘蛛哪些文件夹或路径不要去爬取cssjs等文件对于搜索蜘蛛来说也是毫无价值的,你就是叫蜘蛛去爬取他也不会去爬取的 因为CSS是用来控制网页样式的样式表,JS是用来。

5、搜索引擎在探索网站时,首先会寻找根目录下的robotstxt文件这个文本文件,任何文本编辑工具都能处理,它对网站的爬取策略有着关键作用例如,当你访问abccom,蜘蛛会首先查找abccomrobotstxt,依据其内容决定其访问权限格式化的robotstxt文件包含一系列规则,每条规则由空行分隔quotUseragentquot。

6、Robots文件是一种机器人排除标准协议文件详细解释如下Robots文件的概念和用途Robots文件,也被称为“robotstxt”,是一个纯文本文件,遵循特定的规则与协议它被放置在网站根目录下,用于告知搜索引擎的爬虫机器人如何与网站进行交互具体来说,这个文件可以指导搜索引擎爬虫哪些页面需要抓取,哪些页面。

7、通过Robots协议,网站可以屏蔽一些对爬虫不友好的页面,如网站后台临时活动页面等,以避免资源浪费通常情况下,Robots文件会禁止爬取网站后台在Robots协议中添加Sitemap链接有助于爬虫更高效地抓取网站页面百度官方建议仅当网站包含不希望被搜索引擎收录的内容时,才需要使用Robotstxt文件若希望所有。

8、其核心是robotstxt文件,这个文本文件是通过像Windows Notepad这样的简单文本编辑器创建和编辑的实际上,robotstxt并非一个命令,而是搜索引擎在访问网站时首先查阅的规则文件它的作用是指示搜索引擎哪些页面可以抓取,哪些应被排除在外当搜索引擎的爬虫程序访问网站时,会先检查根目录下的robotstxt,依据文件中。

9、要在网站中查找robotstxt文件,首先需要了解它的位置通常情况下,robotstxt文件位于网站的根目录下因此,您可以通过在主域名后输入robotstxt来访问它例如,如果您的网站域名是。

10、要查看网站根目录的robotstxt文件,可以按照以下方法操作如果是自己的网站 直接访问在浏览器的地址栏中输入你的网站域名,后面加上robotstxt,例如txt,然后按回车键如果网站根目录存在robotstxt文件,它就会被显示出来 本地查看你也可以通过FTP工具或。

11、Robotstxt 是一个由网站管理员或系统创建的文件,主要目的是向搜索引擎爬虫指示网站页面抓取的规则通过“allow”和“disallow”指令,文件告诉“user agents”用户代理哪些页面应该被访问,哪些不应被访问如果网站上传了 robotstxt 文件,搜索引擎爬虫就会根据文件指示抓取网页如果网站没有上传。

12、网站的robots文件用于指示搜索引擎和爬虫哪些内容是可以被访问的,哪些是不应该被访问的UseragentGooglebot表示这段规则是针对谷歌爬虫Googlebot的Disallow表示谷歌爬虫不应该访问网站的根目录而Useragent * 则是通配符,意味着这条规则适用于所有爬虫通过这样的设置,可以控制不同爬虫对。

13、简单来说,robotstxt文件就像是网站的保安,能够决定哪些搜索引擎可以进入网站,以及它们可以访问哪些页面如果设置不当,可能会拒绝所有搜索引擎进入网站,从而导致网站迟迟不被收录怎么在线生成Robotstxt文件 对于不熟悉代码的新手来说,生成robotstxt文件可能会有些困难但幸运的是,有一些在线工具可以。

14、在使用robotstxt文件时,需要注意几个常见的误区首先,robotstxt文件中的内容必须严格遵守大小写规则,尤其是Disallow指令后的冒号,必须保持英文状态这是文件格式的硬性规定,任何改动都可能导致解析错误误区在于,有些人误以为设置所有文件都可以被搜索蜘蛛抓取,可以提高网站收录率实际上,这并不。

15、robotstxt文件是一个文本文件,使用任何一个常见的文本编辑器,比如Windows系统自带的Notepad,就可以创建和编辑它 robotstxt是一个协议,而不是一个命令robotstxt是搜索引擎中访问网站的时候要查看的第一个文件robotstxt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的当一个搜索蜘蛛访问。

16、4 上传文件方法一FTP客户端如FileZilla连接服务器后,进入网站根目录通常为public_html或。

相关标签 :

htm